Mucho se habla de los acelerados procesos de transformación digital y de la adopción de tecnologías emergentes como consecuencia de la pandemia, sin embargo, poco se indaga sobre la evaluación y los resultados de estas soluciones innovadoras, como la inteligencia artificial (IA) ¿Qué buenas prácticas podemos implementar en los procesos?

“No necesitamos buenas intenciones, necesitamos buenas prácticas”.

Veamos algunas cifras y tendencias de los últimos años. En 2021, el 52% de las empresas aceleraron sus planes de adopción de IA debido a la crisis del COVID-19 y el 86% afirmó que la IA se convirtió en una “tecnología convencional” en su empresa. La tasa de adopción promedio en todas las regiones del mundo aumentó 6% en comparación a 2020, quedando en 56 % – y en Latinoamérica pasando del 41% al 47%.

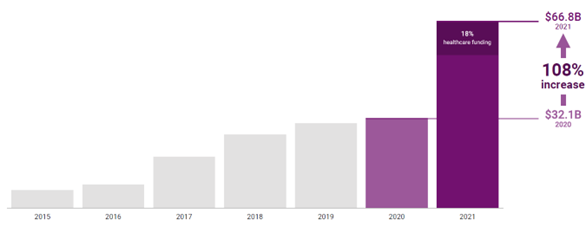

En 2021 la financiación global de la IA aumentó un 108 % (US$66.8 billones) en comparación a 2020. Este aumento estuvo liderado por el sector salud, que representó casi una quinta parte de la financiación total (18%)

Potencial y retos de la inteligencia artificial

La IA tiene el potencial de expandir el acceso a la atención, mejorar los resultados de salud, crear procesos más eficientes y reducir costos. No obstante, la IA puede generar sesgos, lo cual podría tener diversas implicaciones dependiendo del tipo de solución que se implemente. Pensemos en aplicaciones de IA que apoyan la toma de decisiones médicas las cuales impactan directamente a las personas. Es decir, si hay un error o sesgo negativo en la predicción del algoritmo y el personal médico decide tomar una acción a partir de esta, las consecuencias pueden ser fatales.

Por ejemplo, hay evidencia de que reglas simples de predicción de enfermedades cardíacas utilizadas por décadas en países industrializados estaban sesgadas. La puntuación de riesgo cardiovascular – Framingham Heart Study – se desempeñaba muy bien en pacientes caucásicos, pero no en afroamericanos. Cerca del 80% de los datos recopilados eran de población blanca y, por lo tanto, los diagnósticos fueron más aplicables para ese grupo que para otros grupos subrepresentados. Esta problemática de sesgos raciales se repite en algoritmos comúnmente utilizados y en otros grupos poblacionales en ocasiones subrepresentados como las mujeres. Y si se habla de modelos complejos de IA el riesgo es aún mayor.

La importancia de la auditoría algorítmica

En respuesta a estos casos con resultados sesgados, falta de transparencia y mal uso de los datos, se ha generado un creciente interés en tener una investigación más activa sobre los errores algorítmicos y fallas de los sistemas, y un aumento en los pedidos de auditorías éticas obligatorias de los algoritmos como una solución para estos riesgos.

Estas auditorias buscan evaluar un sistema de IA y su proceso de desarrollo, incluyendo el diseño y los datos utilizados para entrenar el sistema, y revisar impactos en materia de precisión, discriminación, sesgos, privacidad y seguridad, entre otros, brindando elementos de rendición de cuentas, transparencia y explicabilidad. El ejemplo de LAURA, una solución brasilera que sin duda es pionera mundial en la adopción de IA en el sector salud, ayuda a entender qué tipo de resultados podría tener un ejercicio como este.

El caso de LAURA y las buenas prácticas en inteligencia artificial

En 2021, el BID bajo su iniciativa regional fAIr LAC, de la mano de Eticas Consulting, realizó una auditoría algorítmica al sistema LAURA – quienes son aliados de la iniciativa y voluntariamente participaron reconociendo el valor de una auditoría para mejorar su solución y estándares de transparencia-. Se realizó un análisis de impacto social para entender qué aspectos podrían limitar el funcionamiento del sistema, y un análisis cuantitativo para detectar y recomendar medidas en posibles casos de discriminación, impacto diferencial o sesgo algorítmico.

Por un lado, el análisis reveló que existe claridad y buena aceptabilidad de LAURA por usuarios finales, por la facilidad de uso y por la transmisión de conocimiento clínico. En términos de protección de datos, tiene una política de privacidad completa y bien estructurada, un estándar de acceso y autenticación con mecanismos de seguridad básicos, con una política de seudonimización que sigue los principios de privacidad en el diseño.

No obstante, evidenció limitaciones en la comunicación a los usuarios sobre el alcance y las restricciones del modelo algorítmico, particularmente respecto al impacto en grupos poblacionales. El análisis identificó que a pesar de tener mayor proporción de población femenina más joven que la masculina, la capacidad predictiva para ese subgrupo poblacional era menor.

Estos resultados informaron al equipo de LAURA sobre las mejoras para mitigar potenciales riesgos éticos en el despliegue de su solución. Este ejemplo evidencia la importancia de evaluar la acelerada adopción de soluciones de IA donde, más allá de las buenas intenciones, se necesitan adoptar estos procesos de evaluación iterativos y periódicos como una buena práctica en la industria. La auditoría algorítmica ya no debería ser vista como un privilegio que pueden tener ciertos proyectos, sino como un requisito que se debería incorporar en las soluciones que tienen impacto directo en el bienestar de la población.

Te invitamos a leer en más detalle el informe final de la auditoría algorítmica de LAURA, así como la guía de auditoría algorítmica que te orientará en el paso a paso para su implementación.

Leave a Reply